人工智能(AI)助理Siri、Alexa的聲線大家都耳熟能詳。它們是智能生活的好幫手,懂得自動翻譯語言,甚至能與人類對話。惟人類與AI的最大區別是人會在溝通過程中傳情達意,作出複雜的反應和交流,這些都是電腦演算法難以理解的。然而,香港中文大學(中大)的研究團隊卻成功以AI技術,用於增強和促進人類之間的交流。

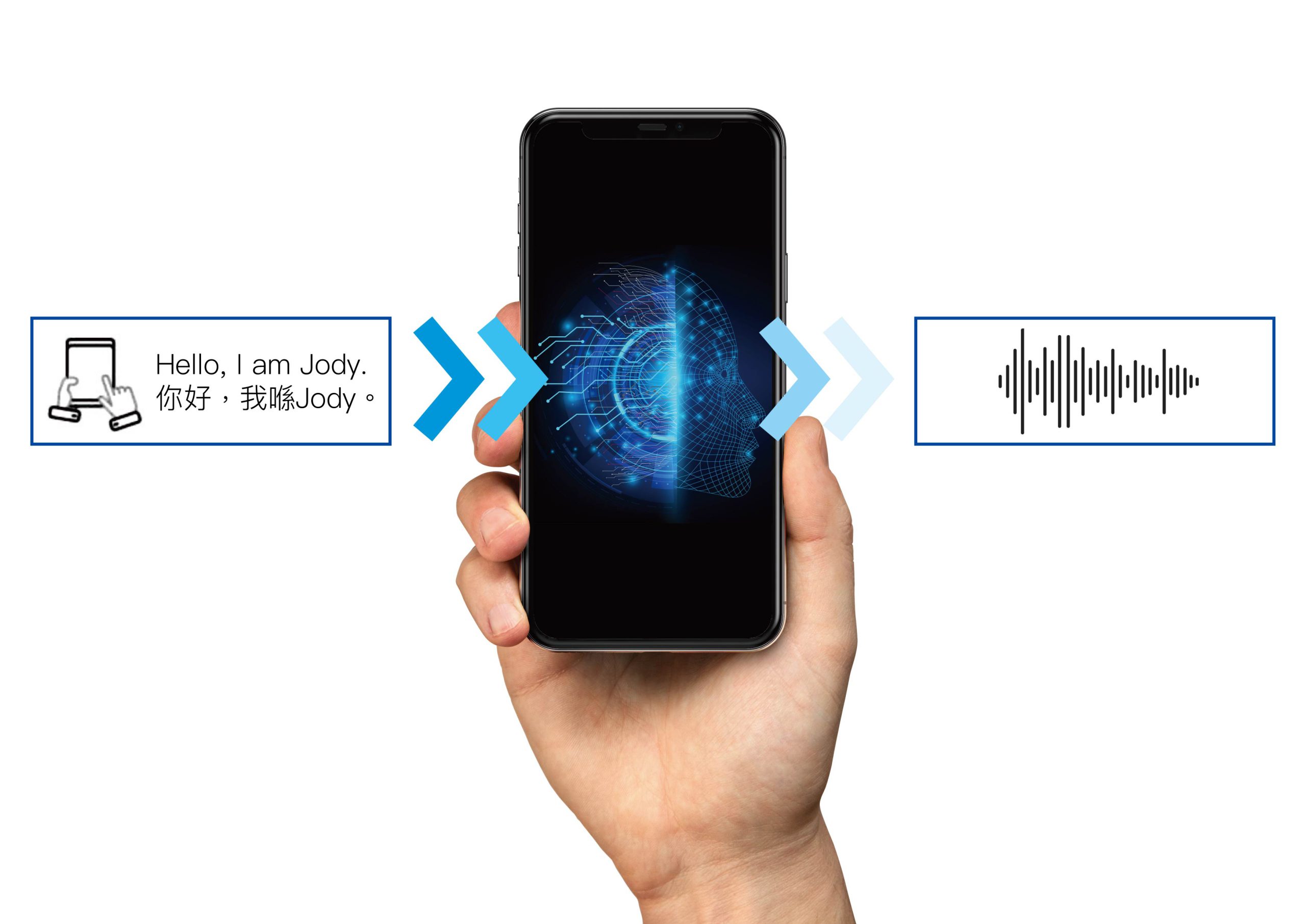

中大電子工程學系李丹教授是深度學習、語音和音頻信號處理專家,多年來醉心於改良語音技術,重現人聲。最近,他便首次利用人工智能技術開發個人化的廣東話語音合成技術(Text-to-speech,TTS),成功幫助舌癌病人Jody「複製」其聲線及說話方式,只要輸入文字便能轉化成病人原本聲音,以便她術後亦能與他人溝通。

團隊先從數據收集開始,與病人進行五次錄音,內容涵蓋不同的廣東話詞彙,如日常對話、講故事和閱讀聖經,以及她常用的語言和說話特徵,例如句法、聲母、輔音、常見用詞搭配和重音等。經實驗室處理後,便建立了一套載有Jody常用語言搭配、語音特徵和措辭的個人數據庫,亦是機器學習用到的訓練數據。由於AI模型是根據數據分析病人的聲音,建構語音合成模型,因此團隊亦盡量在病人完全喪失說話能力前多收集數據。合成後的聲音與病人原聲幾乎無異,如同錄音般。合成聲音載於手機應用程式數據庫,病人只要輸入文字,便能以自己的聲音播出想說的話。

李教授強調,今次項目的最主要目標不是想透過建立語音數據去改善語音輸出的質素,而是想保留語音的原貌。「對病人而言,技術能完整地保留他們最原始的聲線特徵,意義更重大。」他說。

李教授與團隊現正與中大醫學院的專家積極探討該技術用於其他導致喪失說話能力的病症的可能性,如柏金遜或小腦萎縮症,讓更多患者受惠。李教授曾接觸過一些非常熱衷這種技術的病者家屬,但病人因治療過程中已承受了不少痛苦,不想再進行繁複的工序去保留聲線,所以選擇拒絕。「作為研發這項技術的工程師,我不想因為技術已研發出來而不斷去推動病人試用,為他們帶來壓力,而是希望他們在樂意的情況下試用。」李教授補充。

人工智能技術需要大量數據進行模型訓練,數據越多,AI的性能越高。語音技術如要覆蓋說話風格中每一個微小變化,需要大量的錄音數據支持,變相病人要付出更多時間錄音。「要做到這個地步幾乎沒有可能,只會是無窮無盡。」李教授認為,研究要多從病人的角度出發。考慮到人的說話往往帶有重複性,同一語意有多種不同的表達,團隊正研究如何設計最理想的錄音材料,避免不必要的重複,減少錄音的次數,在質素及數量之間取平衡。「我們最終希望開發一套便攜式系統,讓病人在沒有監督的情況下,亦能隨時隨地自行錄音,令收集數據流程更精簡。」